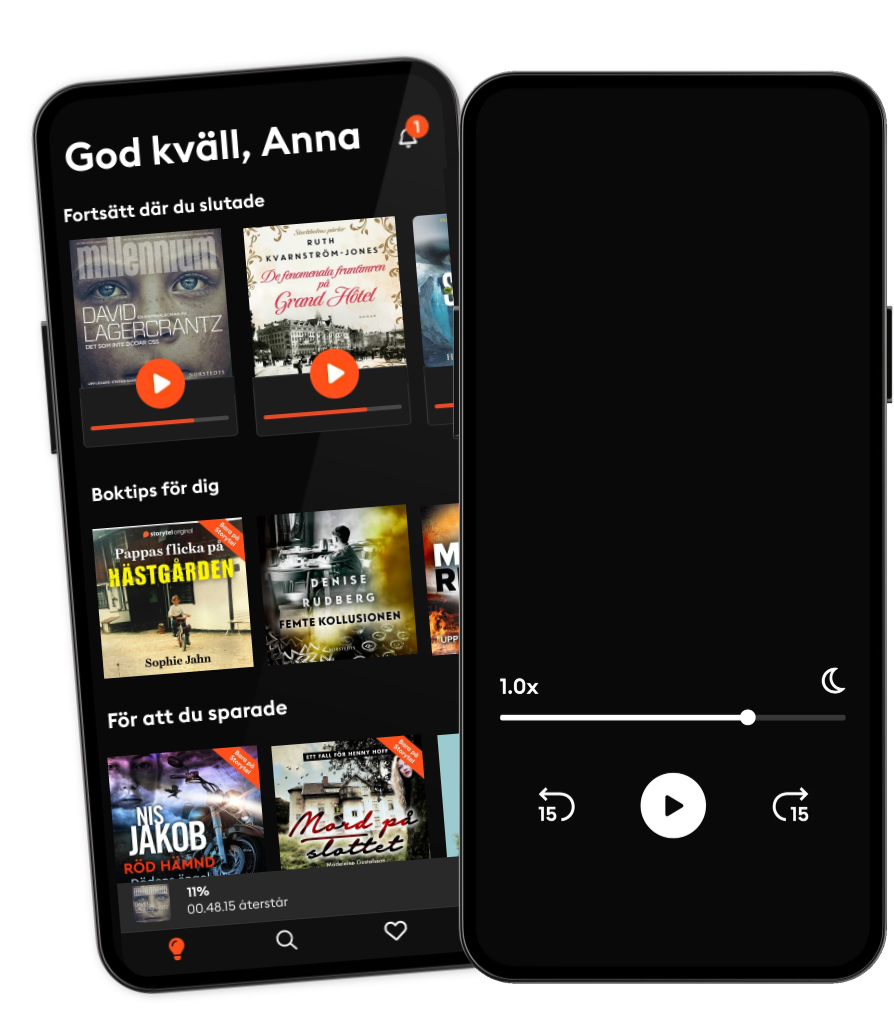

Lyssna när som helst, var som helst

Kliv in i en oändlig värld av stories

- 1 miljon stories

- Hundratals nya stories varje vecka

- Få tillgång till exklusivt innehåll

- Avsluta när du vill

Enhancing Deep Learning Performance Using Displaced Rectifier Linear Unit

- Av

- Förlag

- Språk

- Engelska

- Format

- Kategori

Fakta

Recently, deep learning has caused a significant impact on computer vision, speech recognition, and natural language understanding. In spite of the remarkable advances, deep learning recent performance gains have been modest and usually rely on increasing the depth of the models, which often requires more computational resources such as processing time and memory usage. To tackle this problem, we turned our attention to the interworking between the activation functions and the batch normalization, which is virtually mandatory currently. In this work, we propose the activation function Displaced Rectifier Linear Unit (DReLU) by conjecturing that extending the identity function of ReLU to the third quadrant enhances compatibility with batch normalization. Moreover, we used statistical tests to compare the impact of using distinct activation functions (ReLU, LReLU, PReLU, ELU, and DReLU) on the learning speed and test accuracy performance of VGG and Residual Networks state-of-the-art models. These convolutional neural networks were trained on CIFAR-10 and CIFAR-100, the most commonly used deep learning computer vision datasets. The results showed DReLU speeded up learning in all models and datasets. Besides, statistical significant performance assessments (p<0.05) showed DReLU enhanced the test accuracy obtained by ReLU in all scenarios. Furthermore, DReLU showed better test accuracy than any other tested activation function in all experiments with one exception.

© 2022 Editora Dialética (E-bok): 9786525230757

Utgivningsdatum

E-bok: 25 mars 2022

Andra gillade också ...

- Building, Training and Hardware for LLM AI: A Comprehensive Guide to Large Language Model Development, Training, and Hardware Infrastructure Et Tu Code

- The Year in Tech, 2025: The Insights You Need from Harvard Business Review Harvard Business Review

- Ultimate Python for Fintech Solutions Bhagvan Kommadi

- Human + Machine, Updated and Expanded: Reimagining Work in the Age of AI H. James Wilson

- On the Future: Prospects for Humanity Martin Rees

- New Laws of Robotics: Defending Human Expertise in the Age of AI Frank Pasquale

- The Creativity Code: How AI is learning to write, paint and think Marcus du Sautoy

- Introduction to Blockchain Technology Introbooks Team

- Artificial Intelligence For Dummies Luca Massaron

- Deep Learning John D. Kelleher

- Väninnorna på Nordiska Kompaniet Ruth Kvarnström-Jones

4.1

- Sömngångaren Lars Kepler

4.2

- Ingen Pascal Engman

4.2

- Är det nu jag dör? Leone Milton

3.8

- Död mans kvinna Katarina Wennstam

4.3

- Benådaren Viveca Sten

4.1

- De fenomenala fruntimren på Grand Hôtel Ruth Kvarnström-Jones

4.5

- Kodnamn Verdandi Mikael Ressem

3.6

- Drottningen Jonas Moström

3.8

- De döda och de levande Anders Nilsson

4.3

- Livor mortis Mikael Ressem

4

- Älskade jävla unge Pernilla Pernsjö

4.5

- Anteckningar från aftonsången Jan Guillou

3.5

- Grand final Jens Lapidus

4.3

- Älskade Betty Katarina Widholm

4.3

Därför kommer du älska Storytel:

1 miljon stories

Lyssna och läs offline

Exklusiva nyheter varje vecka

Kids Mode (barnsäker miljö)

Premium

Lyssnar och läs ofta.

1 konto

100 timmar/månad

Exklusivt innehåll varje vecka

Avsluta när du vill

Obegränsad lyssning på podcasts

Unlimited

Lyssna och läs obegränsat.

1 konto

Lyssna obegränsat

Exklusivt innehåll varje vecka

Avsluta när du vill

Obegränsad lyssning på podcasts

Family

Dela stories med hela familjen.

2-6 konton

100 timmar/månad för varje konto

Exklusivt innehåll varje vecka

Avsluta när du vill

Obegränsad lyssning på podcasts

2 konton

239 kr /månadFlex

Lyssna och läs ibland – spara dina olyssnade timmar.

1 konto

20 timmar/månad

Spara upp till 100 olyssnade timmar

Exklusivt innehåll varje vecka

Avsluta när du vill

Obegränsad lyssning på podcasts

Betyg och recensioner

Samlade recensioner

Inga recensioner ännu

Ladda ner appen för att vara med i snacket och lämna recensioner.

Svenska

Sverige